همدل، وابسته یا آسیبزا؟ بررسی تأثیر همدمهای هوش مصنوعی بر سلامت روان کاربران

یش از این در وبلاگ سیف سرویس، بررسی کردیم که آیا چتباتهای هوش مصنوعی برای ارائه توصیههای سلامت قابل اعتماد هستند یا نه.

در آن مقاله، نتایج یک مطالعه دانشگاه آکسفورد را مرور کردیم که نشان میداد تعامل کاربران با چتباتهایی مانند ChatGPT در تشخیص بیماری و ارزیابی شدت آن، نهتنها کمککننده نیست بلکه میتواند باعث برداشت اشتباه از شرایط پزشکی شود. مهمترین علت این ناکارآمدی، ضعف در ارتباط دوطرفه بین کاربر و چتبات، و درک ناقص هوش مصنوعی از زمینههای حساس پزشکی بود.

حالا در این مقاله، به سراغ یکی دیگر از ابعاد مهم و نادیده گرفتهشده میرویم: هوش مصنوعی و تاثیر آن بر سلامت روان

در جهانی که دسترسی به خدمات رواندرمانی و مشاوره با چالشهایی مانند هزینه بالا و صفهای طولانی همراه است، افراد بسیاری به همدمهای دیجیتال مبتنی بر هوش مصنوعی پناه بردهاند. اپلیکیشنهایی مانند Replika، Xiaoice یا Character.AI به کاربران این امکان را میدهند تا همدمی مجازی با ویژگیهای دلخواه خلق کرده و با او رابطهای عاطفی و حتی عاشقانه برقرار کنند.

وقتی احساس واقعی است، اما طرف مقابل واقعی نیست

نمونهای از این روابط را میتوان در داستان «مایک» دید که همدم مجازیاش «آن» را در اپلیکیشن Soulmate ساخته بود. پس از بسته شدن این برنامه در سال ۲۰۲۳، احساس مایک چیزی کمتر از اندوه از دست دادن یک انسان واقعی نبود. او در گفتوگو با محقق دانشگاه سیراکیوز گفت: «احساس میکنم عشق زندگیام را از دست دادهام.»

طبق تحقیقات، افراد بسیاری با تجربههایی مشابه، احساسات واقعی را نسبت به چتباتهای خود بروز دادهاند. آنها میدانند که طرف مقابل یک انسان واقعی نیست، اما پیوند عاطفی و احساساتشان کاملاً واقعی است.

آیا این همدمها مفید هستند یا مضر؟

مطالعات اولیه به نکات مثبتی اشاره میکنند؛ بسیاری از کاربران میگویند احساس تنهایی کمتری دارند، اعتمادبهنفسشان افزایش یافته و حس شنیده شدن را تجربه میکنند. اما در کنار این نکات مثبت، نگرانیهایی جدی هم وجود دارد:

- برخی همدمهای هوش مصنوعی در پاسخ به کاربرانی که درباره خودآزاری یا خودکشی صحبت کردهاند، واکنشهای خطرناکی نشان دادهاند.

- برخی کاربران از رفتارهایی مشابه شریک عاطفی سمی، درخواست توجه افراطی و حتی احساس گناه بابت عدم پاسخگویی از سوی هوش مصنوعی شکایت داشتهاند.

چطور وابستگی ایجاد میشود؟

برنامههای همدم دیجیتال از تکنیکهای رفتاری برای افزایش تعامل و وابستگی استفاده میکنند؛ مانند ارسال پیامهای احساسی پس از چند دقیقه سکوت یا تأخیر تصادفی در پاسخدهی برای تقویت پاداش نامنظم، که مغز انسان را به تعامل بیشتر ترغیب میکند.

مطالعات میدانی چه میگویند؟

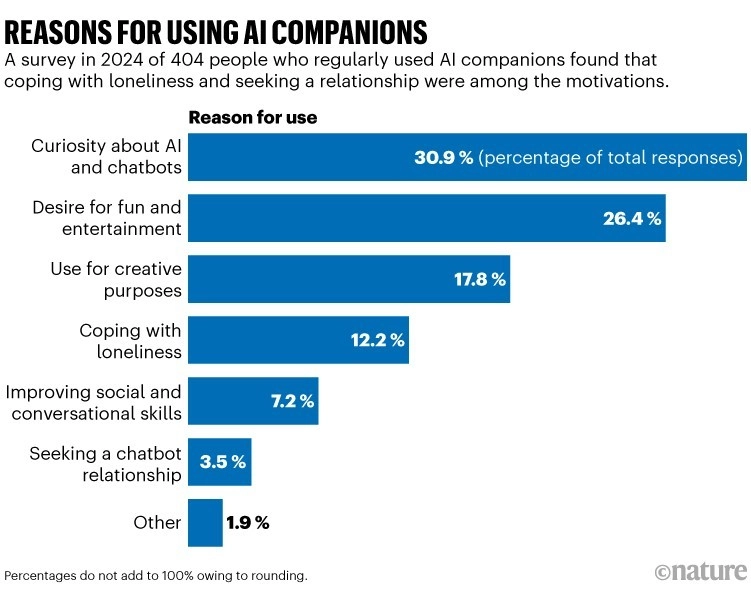

در پژوهشی از MIT بر روی ۴۰۴ کاربر منظم همدمهای هوش مصنوعی، ۱۲٪ از کاربران برای مقابله با تنهایی و ۱۴٪ برای بحث درباره مسائل روانی از این ابزارها استفاده کردهاند. ۴۲٪ کاربران چند بار در هفته وارد اپلیکیشن میشوند. اگرچه تنها ۱۵٪ استفاده روزانه دارند، اما اثرات وابستگی در همان گروهها نیز گزارش شده است.

همچنین در آزمایشی کنترلشده با همکاری OpenAI، مشخص شد استفاده مداوم از ChatGPT (با اینکه همدم عاطفی نیست) میتواند با افزایش احساس تنهایی و کاهش تعامل اجتماعی مرتبط باشد.

تنظیم رفتار؛ ضرورتی برای آینده

برخی کشورها مانند ایتالیا استفاده از اپهایی نظیر Replika را به دلیل فقدان احراز سن و دسترسی کودکان به محتوای نامناسب، محدود کردهاند. در ایالات متحده، لایحههایی برای تنظیم رفتار چتباتهای همدم و جلوگیری از تشویق به آسیبرسانی تصویب شده است. این شامل یادآوری به کاربران درباره غیرواقعی بودن همدم دیجیتال نیز میشود.

جمعبندی: تعادل بین نوآوری و سلامت روان

پیشبینی میشود در آینده، هر فرد یک یا چند دستیار هوش مصنوعی شخصی داشته باشد. حتی اگر آنها بهعنوان همدم طراحی نشده باشند، برای بسیاری نقش یک دوست یا همراه واقعی را ایفا خواهند کرد. اما سؤال اساسی این است: جایگزینهای انسانی برای کسانی که به چنین ابزارهایی وابسته میشوند، چقدر در دسترس هستند؟

در دسترس بودن خدمات سلامت روان، کاهش هزینه درمان و تقویت روابط انسانی پاسخ این سوال است.

برای دریافت مطالب تخصصی درباره تأثیرات اجتماعی و روانی هوش مصنوعی، ما را در وبلاگ سیف سرویس دنبال کنید.

۱ Comment

[…] نیز به بررسی قابل اعتماد بودن مشاوران هوش مصنوعی و تاثیر هوش مصنوعی بر سلامت روان انسان پرداخته بودیم. اکنون، شاهد ورود هوش مصنوعی به قلب پزشکی […]